【EV视界综合报道】近日,在第四届智能汽车域控制器与中央计算平台创新峰会上,爱芯元智智能算法高级总监李琛分享了关于自动驾驶软硬件架构的变革进程,从算法架构、传感器构型等层面来划分智驾方案的进化,这一划分因自动驾驶端到端技术的融入也发生了巨大的变革。

爱芯元智智能算法高级总监 李琛 (图片来源:盖世汽车)

在变革的进程中,爱芯元智作为SoC厂商,都做了哪些思考和落地实践?李琛也做了全面的阐述,以下为具体演讲内容。

智驾算法架构发展趋势剖析

传统CV到CNN再到端到端大模型

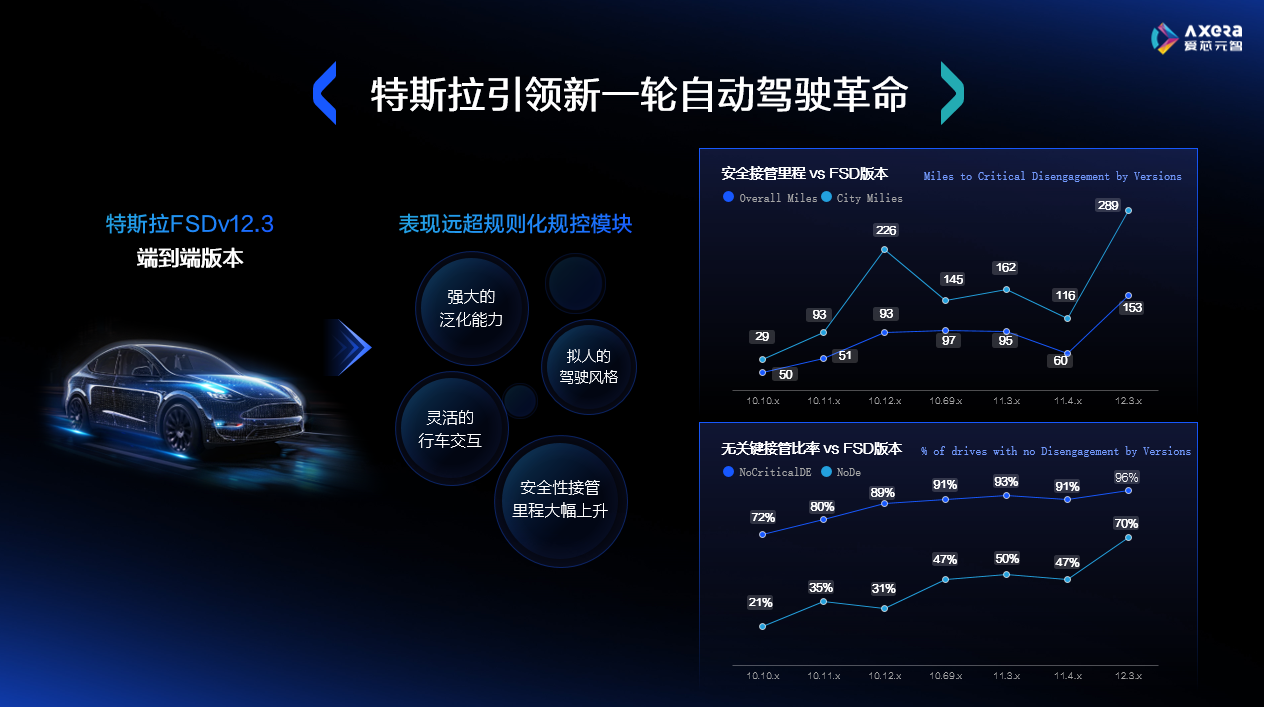

2023年11月份,特斯拉发布了FSD的V12版本,表现惊艳。跟之前的智驾系统相比,V12版本具有强大的驾驶泛化能力以及拟人的驾驶风格。V12版本相比较于之前的接管里程,大幅增加,更重要的是,里面包含的城市工况,比例也很高。

第二张图展示的是驾驶员从A点到B点的无关键接管成功率,以及完全无接管成功率。可以看到,随着版本的迭代,都在稳步上升;尤其是在V12.3版本中,完全无接管比例快速攀升。从V11版本的47%,攀升到了V12版本的70%。用户体验也大幅上升。

随着端到端技术的突破,对当前智驾方案也会产生深远影响。

这里为大家做一个智驾方案演进的梳理。

如果我们把一体机方案定义为智驾1.0阶段,那么可以认为这个阶段的感知方案是基于CNN甚至传统CV的,配合后端的rule-based规控算法形成完整方案;

2.0阶段通过引入更多摄像头来解决一体机视角不足的问题,自然的想法是复制多份类似一体机感知的模块,然后通过后处理进行结果的融合,BEV算法架构则是通过网络的方式做到了更优的多视感知融合;更进一步的,还有很多像目标检测跟踪、车道线拓扑等后处理;

在3.0阶段,可以通过Transformer模型来进行更好的建模,通过数据驱动的方式做到自适应优化;OCC的提出则试图拓展一般目标检测模型的不足,即对于预定义类别之外的一般目标的泛化检测能力;这时候整个大感知模块基本实现了网络模型化设计,我们可以称之为感知端到端,而也有部分方案开始探索在规控中加入部分AI规控范式以优化部分rule-based方法处理不好的特定场景,但因为AI规控并不成熟和完备,因此都是混合形态,仍需要传统规控兜底。而因为这时候感知和规控之间的连接仍然是人工定义接口,有时也可以称为Two Model形态。

FSD v12.3对应的是4.0阶段,这时候通过query-based隐式表达接口,打通了从规控到感知的反向梯度优化,让整个系统变成了真正的端到端数据驱动优化系统。近期大火的生成类大模型,被认为具备深层次分析能力和通用泛化能力。智驾行业中,也开始有很多将大模型引入的尝试,以处理高阶智驾中的复杂场景和长尾问题。但因为其规模较大,当前智驾处理芯片无法做到实时处理性能,但类比人脑在处理复杂路况时,也会从下意识的肌肉记忆操控模式,转变为三思而后行的方式,本身处理复杂路况时的策略和规划控制可以被认为是一种准实时动作要求。由此引入快慢系统,我们一般称为大小脑系统。我们认为该方向具备较大潜力,因此在后续芯片产品规划设计中,也会进行系统性评估。

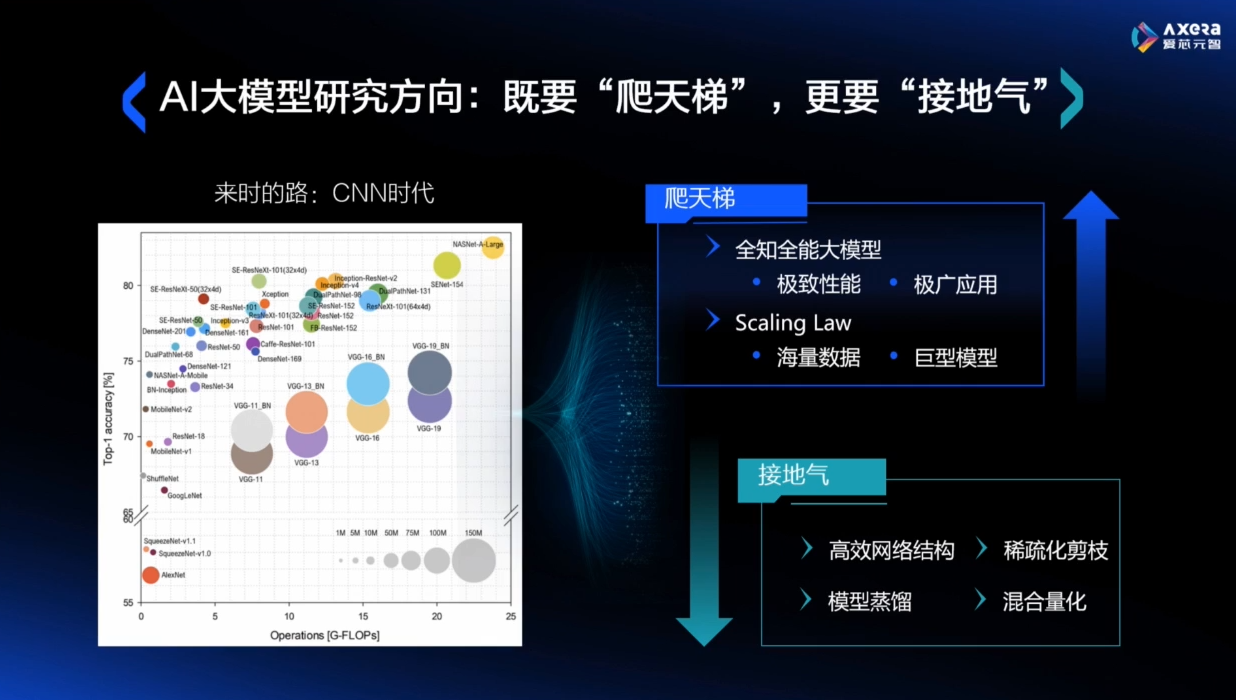

刚才提到,大模型的一大挑战是规模巨大,如何实时可靠地落地端侧处理平台是个大考验,不妨看看来时路。

左侧图展示了CNN时代算法的演进路线。横坐标是模型计算量,纵坐标是性能。自2012年AlexNet被提出,性能大幅超越传统CV算法,一时带起了CNN的热潮,各领域都在刷CNN算法,并通过不断增大其规模快速提升性能。在论证完性能达到一定要求之后,业界开始思考如何在保持性能的基础上,将所需算力降下来,以落地更多实际产品,这时开始向左转迈步走。比较成功的案例像MobileNet、ResNext后续也开始走效率路线、还有一些nas搜索出来的高效网络结构。同样的,在当前Transformer时代,大模型的爆火实际对应CNN第一阶段的粗犷的开疆拓土阶段,接下来可能要精打细算。

既要爬天梯也要上天揽月,比如充分利用Scaling Law,通过海量数据+巨型模型,取得所谓全知全能的Omni大模型;但另一方面,也会有越来越多的工作,开始关注如何将现有成果更经济更实际的落地到有限资源的端侧。像高效网络结构设计、模型蒸馏都是可行的方向。当然我们也提前做了一些工作证明,大模型的深层和高维特性,也给稀疏化剪枝、混合精度量化这些轻量化方法带来了足够的优化潜力。

爱芯元速高性能SoC

助力自动驾驶算法架构变革

那从智驾芯片设计的角度,能够提供哪些助力?

首先硬件底层的异构多核设计,可以保证最大程度地并行化处理。

通过软硬件协同设计,可以最大程度地确保数据和与之相关的运算能够编排得足够紧密。我们有很多网络模型能够实现除了输入到输出,中间计算完全在线无DDR交互的极致高效运行状态。

第三,应对未来性能和效率不断推动的算法演进,我们设计的指令集系统可以不断进行灵活适配,更新先进的算子库和架构库。上面提到的低比特量化和稀疏化剪枝,我们也做了硬件级别的高效支持。

最后,片间互联设计可以确保芯片级的可拓展性,以应对超大规模算力系统需求。

爱芯元智芯片设计性能优异的表现,首先体现在对于Transformer的支持在业界是最早和最好的,相比于旗舰竞品,爱芯元速M76H,SwinT性能可以做到超越。综合功耗看FPS/W的指标,更是达到10倍的差异。同时传统CNN的各类算子,相比于同级别的友商域控产品,也有较大优势。

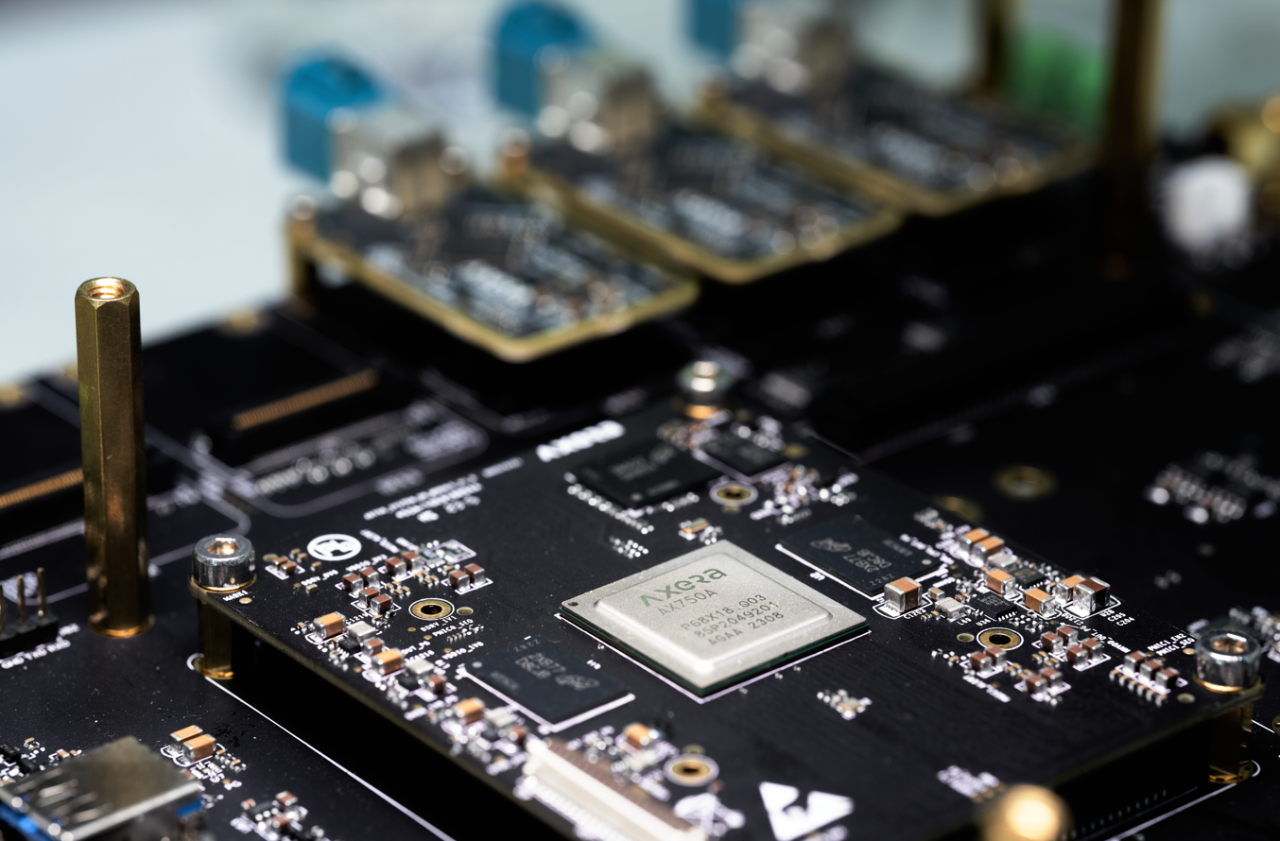

爱芯元速M76H域控参考设计

另外软硬协同角度,首先我们有一系列成熟易用的工具链,也得到业界的广泛认可;同时我们会从训练到部署的完整链条,全面支持以上的各种特性以及高级玩法。

这里强调一点,爱芯元智的算法研发团队会不断维护和更新一个贴合车载业务需求的算法库,从算子到模型,再到系统层面,全方位地对我们的智驾芯片产品进行设计和论证闭环。保证产品的竞争力。

我们对M76域控平台的潜力做了进一步挖掘和尝试。首先左侧可以看到基于高效的BEV架构支持,M76可以完成实时OCC占据网格的处理,增强通用感知能力。

我们更是尝试部署了一个大语言模型和VLM视觉语言混合模型,可以看到LLM可以在M76端侧进行正常的语言交互,这里回答了一个问题和完成了一个简易的编程作业;VLM Demo中更是可以看出,其对于预定义任务之外的开集检测的泛化潜力。

关于纯视觉和多模态的智驾路线之争。爱芯元速的观察是认为视觉作为主线基础路线,同时多模态路线也能对其进行拓展以实现可靠高阶智驾的加速落地。

从第一性原理角度来看,大家都认可人可以光凭眼睛的输入做到自主驾驶,那么机器也可以只依赖摄像头输入。但注意,人的整个感知系统中还有一个经过长久进化的复杂大脑来处理视觉信号,目前已有的智驾处理器显然在处理能力上还不及大脑。所以完整的第一性原理告诉我们,有可行性,但仍存在较大提升空间。

那么,不妨从多传感器融合的角度给一把助力,眼观六路+耳听八方,增加横向处理能力,来弥补纵向处理深度的不足。而且从传感器特性也能看出,这几类传感器具有较好的互补性,M76域控平台在优秀的图像处理能力基础上,还支持各种Radar和LiDAR的信号前处理,从而具备多模态前中融合的系统能力。

下面的例子是和生态伙伴共同做的一个尝试,可以看到视觉和Radar的融合,能很好地产生1+1>2的效果,结果就是在点云密度上得到提升,对于过曝和死黑的图像部分,也能具备稳定的检测能力。这只是尝试之一,M76域控平台可以灵活地做到视觉、Radar和LiDAR的不同融合方案。欢迎更多合作伙伴进行合作和尝试。

爱芯元速智驾芯片全面产品布局

作为一家SoC创新研发企业,爱芯元速智驾芯片产品布局全面。

M55平台应对一体机产品的高效能CNN推理,支持混合低比特量化提速;M76平台面向中阶域控,全面支持各类BEV框架、原生支持高效Transformer算子和多模态融合方案,可以做到上面定义的智驾2.0-3.0系统,也就是BEV感知,并且拓展一些感知端到端功能如OCC、Transformer轨迹预测规划等分立模块。在研的M77平台则可以做到完整规控级端到端,并且在大模型方面支持相对轻量级的专家大模型(如7b以内)进行准实时推理,拓展方案的高阶泛化能力。后续的M9则会朝着实时专家模型+准实时通用大模型做升级,实现端到端乃至全知全能的理想型智驾方案。

爱芯元速在推动SoC车规级量产落地方面进展很快,M55H芯片已经在多款车型完成定点量产,到目前出货量达到数十万片,2023年在国产ADAS SoC市场排名第二。也是行业最快速达成量产的芯片。目前针对M55/M76两款芯片诸多量产项目正在紧锣密鼓的开发中,拓展形态覆盖CMS、行泊一体系统和中高阶智驾系统。而且今年我们也收获了诸多新客户,包括新势力车企、自主品牌车企、合资车企等等,量产节奏正在快速推进中。后续都将以具体的车型产品与大家见面。

爱芯元速专注做好芯片,定位Tier2,服务我们的国内外Tier1、软硬件合作伙伴,进而服务好车企客户。依靠着自研技术IP、强大的供应链能力、关键器件的定制,全方位满足客户对车载SoC的需求,同时满足车企出海需求。

目前,爱芯元速在车载SoC出货方面已达到初步规模化,据国内权威机构统计,其在国产ADAS芯片出货量榜单排名第二。也因为出色的商业化进展,爱芯元速被国际权威分析机构Canalys列入“中国ADAS SoC厂商矩阵”的冠军阵营。

爱芯元智一直是一家崇尚技术创新的公司,在车载SoC研发领域,我们也秉持创新的理念。我们每一代芯片都做了提前的技术布局,契合智驾行业发展的趋势,顺应技术演进方向,这也是我们能快速起步的原因。后续,我们还将持续推进智能计算技术的迭代,为客户创造更多价值。