【EV视界报道】如今在国内,新能源汽车的发展已经逐渐的进入了下半场,而进入这个下半场的“门票”,莫过于自动驾驶的能力了。

在我们看来,自从高级别的自动驾驶能力开始被量产,主机厂在这方面的投入也是不遗余力,力争成为行业的翘楚。但这个领域不同于传统造车,这里面的“玩家”已经不再局限于传统主机厂,软件公司的加入,也带动了整个行业的快速发展,让国内的自动驾驶研发能力成为了具有挑战全球行业的勇气,百度就是其中之一。

作为最早参与自动驾驶研发的企业,百度早在2011年就提出了一件名为“一种数字地图生成装置及方法”的发明专利。自这件用以优化地图导航底层技术的专利开始,此后的时光中,10数件地图导航与汽车驾驶地理坐标相关发明专利相继涌现。而这个时期可被视为百度自动驾驶技术的萌芽期。到了2013年世界互联网大会乌镇峰会上,百度展示了自己改造的首辆自动驾驶汽车,而之后的2015年,百度用一台宝马3系改装车完成了国内无人车首秀,并且从北京新高速到五环进行了最高速度达100公里/小时的自动驾驶演示。

所以有了前端的铺垫,在国内自动驾驶的领域中,百度通过不断地研发与推广,早早的在自动驾驶行业中占据了“领先”位置,因此就有了足够的底气与信心,并向行业证明了自身的技术实力,近日举办的百度Apollo Day就是很好的例子。

会“动脑”的自动驾驶

对于自动驾驶来说,相比较在高速路段的驾驶,在城市中的运用是最为考验技术的重要难关。一般来讲,城市道路错综复杂,你永远不知道什么时候会有电瓶车横穿马路;什么时候会有行人突然出现;什么时候会有慢行车挡路;什么时候会有其他车辆变道加塞。这种需要依靠自身经验,无固定性的行驶场景,在自动驾驶领域被称之为Corner Case,也就是复杂场景,比如当你驾车正要变道的时候,突然有车辆要从旁边“加塞儿”进来,而你会将如何处理?是退回原位?还是继续变道?诸如此类无法确定走向的问题,都可以被称为复杂问题。目前如果要在城市道路中开启自动驾驶的话,90%面对的是常规问题,而剩下的10%就是复杂场景了,这也就是自动驾驶最为关键的所在。

相比较我们常见的自动驾驶能力,百度Apollo安全性最大的优势就在故障处理策略上,在面对自动驾驶中的不同场景,通过对仿真系统的完善,百度Apollo不仅具备即时处理安全问题的能力,还能不断对其进行云端调整。

这种调整是百度Apollo通过把"不确定因素"放入云端,仿真系统对其进行模拟判断,判断标准有两个——“知道不知道”与“安全不安全”,在云端不断模拟之下,当路上遇到相同情况的时候,这些模拟场景均会被调用,这种体系之下,安全性就会被逐步加强。

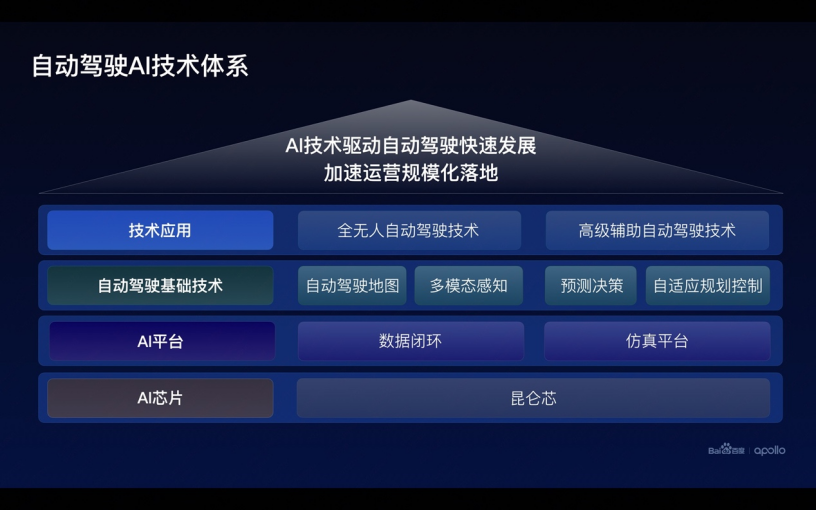

另外,在构成自动驾驶的基础技术方面,包括自动驾驶地图、多模态感知、预测决策、自适应规划控制等四个方面,它们是构成百度自动驾驶技术的基石,也是本次百度Apollo Day上的重点。

高精地图与大模型,双管齐下的倍增器

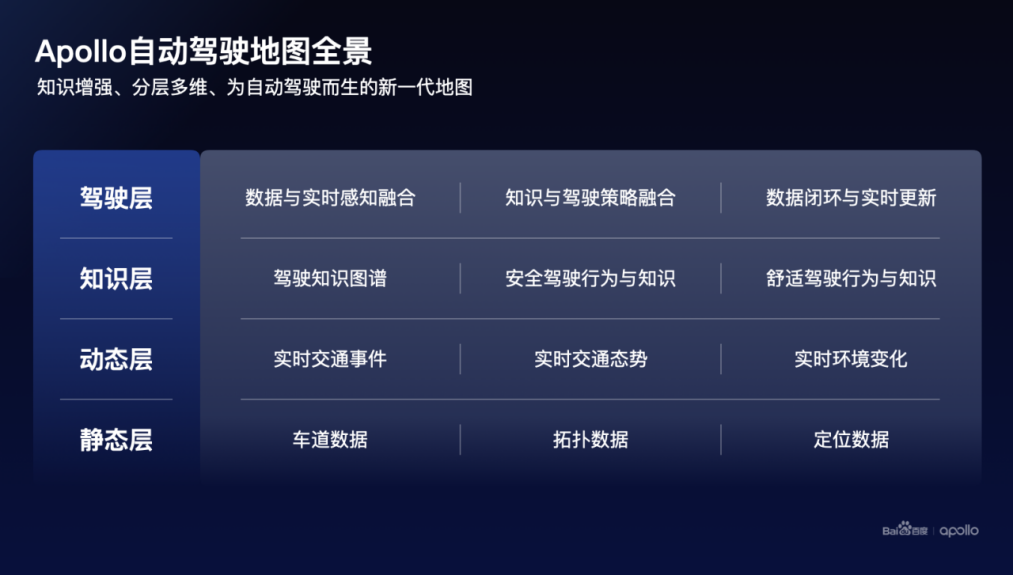

说到自动驾驶地图,我们首先想到的莫过于高精地图。但随着行业的发展,越来越多的企业认为高精地图一定是过渡,云端的结合也只是一个辅助,所以就有了" 重感知,轻地图" 的认知。而作为高精地图提供商之一的百度确不这样认为,并公开表示,对于 L4级自动驾驶而言,要达到99.99%以上的成功率,地图是不可或缺的底层能力,特别是在应对道路标识出现遮挡、污损、新旧重叠时,单靠实时感知是无法解决的。

不过,要想研发一套完整的高精地图,需要的研发周期长、成本高昂,所以这不是一般的企业能够承受的。因此,百度Apollo的自动驾驶地图要完成“轻成本,重体验”的目标。

首先在“轻成本”上,百度用自动化数据融合让地图的成本大大降低,这主要是通过对所有地图数据的收集、小块处理并进行几何融合的方式,完成最终自动驾驶地图的形成,百度克服了包括块状地图融合的精度、场景化的关联、重叠部分的融合效率等等难点,最终达成了“轻成本”目标。目前,在高精地图层面,AI是降本增效的核心驱动,百度高精地图构建自动化率已达到96%,大幅解决了应用成本高的问题。

而在“重体验”上,百度Apollo主要是针对一些在实际场景中,包括多次变道、突发限速等情况都会让乘客的体验变差,这时候百度提出了“驾驶知识图谱”,即基于百度地图1200万公里的领先路网覆盖范围及海量时空数据,结合数亿司机的驾驶知识沉淀,构建全路网级别的驾驶知识图谱,而这个图谱包括:行驶速度、变道时机、变道轨迹等等。这一层输入,是自动驾驶由笨拙变得顺滑的关键。如此让系统学习人类司机经验,用驾驶知识图谱为自动驾驶搭建进步的阶梯。

那么,百度Apollo如何做到让自动驾驶逐步学习的呢?这里就要提到一个概念——大模型。

在自动驾驶发展过程中,多传感器的融合是达成目标的必要条件,这其中算法成为了整个系统的核心内容。在之前的百度Apollo自动驾驶感知1.0中,系统是以激光雷达为主,加入环视、毫米波的后融合感知方案,后融合是以规则驱动的,若出现一些特殊情况(小动物、货车外凸的货物等),往往这种算法就会出现误判,这肯定不符合自动驾驶的要求。而随后出现的感知2.0是多模态、前融合、端到端的方案为主;除此之外,补充以远距离的视觉感知以及近距离的鱼眼感知,而在这其中,大模型发挥的作用包括数据挖掘、数据标注等等。

百度Apollo的大模型技术能够让自动驾驶在短距离、中等距离与远距离都能有不错的表现。大模型算法主要有两个方面的新内容,首先是有关新模型的判定,2D数据容易获取,3D数据获取相对困难。可以利用2D标注数据和3D标注数据,迭代自训练的方法得到一个效果不错的感知大模型,再利用大模型对数据进行3D的伪标注,让大模型下沉到小模型,并且在实际场景中大型模来帮助小模型解决自动驾驶中的误判,比如在道路上遇到对向洒水车正在洒水的情况,大模型会判断对向的洒水车,从而帮助车型判断出“洒出的水”这个小模型,减少对“水”的误判情况。随着各个大模型的叠加,这种训练会越来越简单,越来越快,自动驾驶算法在实时判断也会更准确。

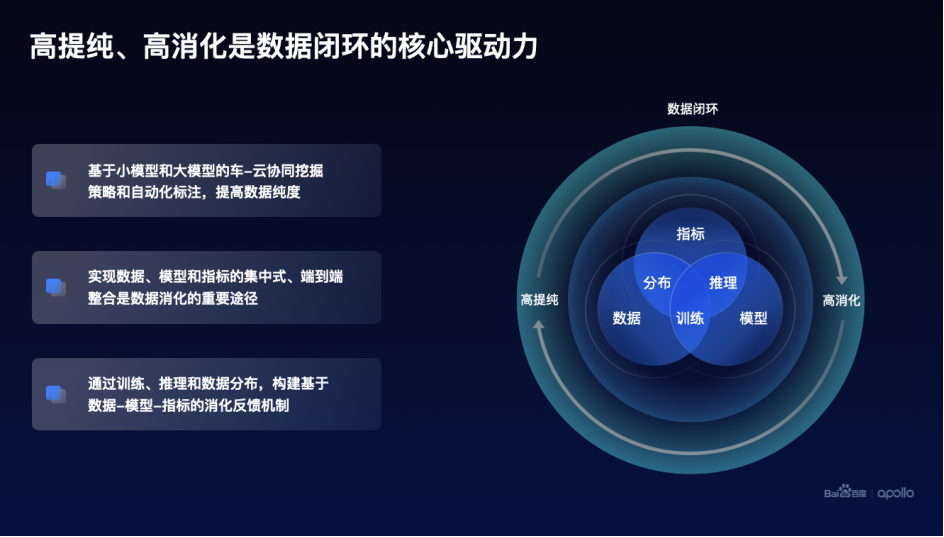

另外,在自动驾驶的过程中,车辆会遇到各种意想不到的场景,比如 羊群过马路。解决罕见、长尾场景,是数据闭环的价值。与感知、规控、决策的技术栈相比,大规模数据闭环的建设是行业里的崭新命题。

数据闭环的前半是大量数据带来的存储和标注的压力,后半是大规模数据用于训练的计算量需求暴增。百度Apollo设计的数据闭环,核心是解决「高提纯、高消化」的问题。

在数据提纯上,百度的方案是利用车端小模型+云端大模型,做高效的挖掘和自动化标注;数据消化架构,实现自动化训练,具备联合优化和数据分布理解的能力,利用高纯度的数据进一步提升自动驾驶系统的整体智能水平。除此之外,训练、推理以及数据分布在数据消化过程中,形成:数据-模型-指标的消化反馈机制,进一步提升数据消化的整体效率和效果。

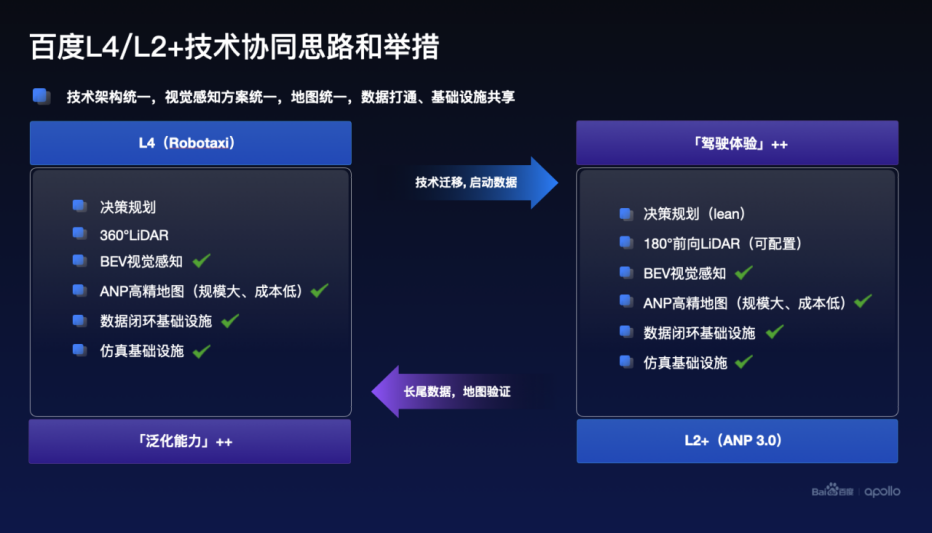

技术共生路线,昆仑芯片即将助力百度

百度的自动驾驶路线为 L4/L2+ 技术共生路线,是行业第一家同时具备L4 Robotaxi技术和量产L2+辅助驾驶方案的公司,百度自动驾驶技术专家王亮认为,百度赋能汽车智能化的信心和底气源于十年自动驾驶技术沉淀。目前,技术栈层面已实现L4与L2+智驾产品视觉感知方案统一、技术架构统一、地图统一、数据打通及基础设施共享。L4将持续为L2+智驾产品提供先进的技术迁移,L2数据反哺也将助力L4泛化能力提升。同时,王亮也强调高精地图是保障L2+城市级智驾产品高安全、体验好的必要条件。

除此之外,在软件上的建树,硬件方面也成为了近期自动驾驶行业的另一个焦点。众所周知,随着世界风云的改变,芯片已经成为决定行业生存的关键之一。在百度Apollo Day技术开放日上,昆仑芯科技CEO欧阳剑透露,百度自研AI芯片昆仑芯2代已完成无人驾驶场景端到端性能适配,这也将持续夯实百度Apollo软硬一体优势。

其实,百度自研的昆仑芯片已经量产了两代,实现数万片的商业化部署。第三、第四代产品都在研发中,三代芯片预计明年量产,四代芯片后年量产。

昆仑芯片采用的XPU-R架构,通过7nm先进工艺,能够达到128TFLOPS FP16的强大算力,完全满足自动驾驶的需求,除此之外,昆仑芯二代还拥有32GB的高速闪存以及512GB/s的内存带宽,并且支持虚拟化,芯片间互联和视频编解码,是非常完备的AI芯片。而对于行业来说,昆仑芯片也具有着以下几点优势:首先昆仑二代AI芯片已经在互联网,工业质检、智慧交通智慧金融等场景均有实际部署,也证明了该芯片的可行性;其二是昆仑芯片已与多款通用处理器、操作系统、AI框架完成端到端的适配;其三昆仑芯片专门为开发者提供了全方位的软件工具包,让大家都能更简单的对昆仑芯片系统进行独立个性化的开发与定制。

目前昆仑芯二代已经在百度的Robotaxi系统上进行了完整的适配,并开始道路测试。

告别堆料,ANP3.0让自动驾驶“眼光发亮”

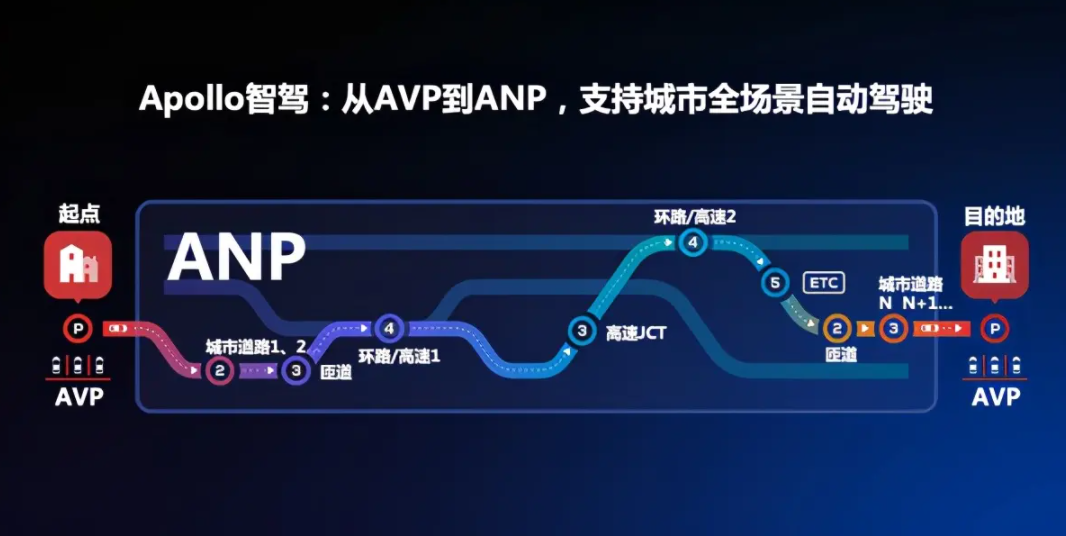

在本次百度Apollo Day技术开放日,重头戏莫过于百度ANP3.0自动驾驶方案了,它将在国内率先支持复杂城市道路场景,并且衔接融通高速和泊车场景。

相比于某些品牌的“堆料”做法,硬件上百度选用了包括500+ TOPS AI算力得到Nvidia Drive Orin-X,max视距~400m的环视8MP摄像头、1,536,000 points/s的SOTA半固态激光雷达。在系统的构成上,ANP3.0将以视觉方案为主,将激光雷达作为安全冗余来做支持。

ANP3.0所搭载的第二代纯视觉感知系统Apollo Lite++通过Transformer把前视特征转到BEV,在特征层面对相机观测进行前融合后,直接输出三维感知结果,并融合时序特征实现运动估计Learning化。

可以说,百度视觉感知方案Apollo Lite是世界唯三、中国唯一支持城市道路的纯视觉,自动驾驶的感知系统;LiDAR则是由百度Apollo十年深耕,算法理解、实践经验和数据储备全面领先,成熟可靠的激光雷达方案。在两种系统的加持下,百度自称是“国内唯一真‘冗余’的环境感知系统”。通过Transformer把前视特征转到BEV,在特征层面对相机观测进行前融合后,直接输出三维感知结果,并融合时序特征实现运动估计Learning化。

模型设计层面,基于transformer结构,实现时空特征融合。之后,在空间融合阶段将位置编码变换从全局BEV空间转换到局部相机坐标系,消除相机内外参差异带来的差异。时序上尽可能多的融合主车运动与多帧信息,提升障碍物检测稳定性。同时基于时序特征,障碍物的速度、意图、未来轨迹预测等关键信息都可以进行端到端的输出。另外,对后处理的多相机融合依赖更低,算力需求更轻,泛化性更好。

目前ANP3.0已进入北上广深多地泛化测试阶段,将在2023年夏天随着第一个客户车型上市与大家见面。

写在最后

可以说,百度Apollo Day技术开放日首次对外全面展示了其智能驾驶的技术路线,并让我们了解到了百度在自动驾驶系统感知、预测决策、规划控制,以及数据闭环、地图、算力等全链条技术方案,更深层次的也让我们真正了解到了未来的无人驾驶会是什么样子。相信,随着技术的发展,中国无人驾驶的商业化进程正逐步从点连成线,特别是在消费端,中国消费者对自动驾驶的接受度也越来越高,而这对于我们向发达国家“弯道超车”起着至关重要的进步。 因此,百度能否在这“下半场”发展中再次引领行业,未来的发展又将发生怎样的变革?我们拭目以待。